“今天,当我们再次拜读他们杰出的工作成果—弗朗索瓦·斯密纳德关于19世纪工资演变方面的工作、欧内斯特·拉布鲁斯关于18世纪物价和收入历史方面的工作,或是让·布维尔和弗朗索瓦·菲雷关于19世纪利润变化趋势的工作—很明显这些学者为了汇编和处理他们的数据不得不克服了大量的技术困难。在许多情况下,他们需耗费大量精力来解决技术上的难题,然后才能进行分析和解读,尤其是在进行跨国、跨时间段数据对比时,这对他们的技术能力提出了极高的要求。比起过去,如今研究财富分配的历史已经容易得多。本书极大地得益于研究技术的最新进展。”

——托马斯·皮凯蒂,《21世纪资本论》

上一篇《BI简史:穿越数据迷雾的探索之旅(上)—BI的起源与奠基》用较长的篇幅简述了21世纪之前影响BI形成的需求、技术、理论,随着社会复杂度提升,人类逐渐从简单的分类计税发展到有视窗操作界面的数据分析与决策支持系统。

本篇介绍本世纪头20年对BI有重要影响的技术、理论、需求。在本篇,我们可以更清晰地看到技术、理论、市场需求共同作用下,BI从最初的1.0时代,迭代至2.0时代,BI的灵活性、民主性受到重视,但BI的陡峭的学习曲线、数据处理与反馈非即时性、观察维度易偏狭的问题,也日渐凸显。

2000年代~2020年代,数据处理理论和技术突飞猛进

数据仓库、ETL工具、数据库、分布式数据存储等领域都取得了实质性的进步,使企业能够更有效地处理大型数据集,并做出更快、更可靠的决策,并持续影响着今天的数据仓库领域,特别是在可伸缩性、速度和数据集成方面。

2010年代,Nathan Marz在2011年提出了Lambda数据仓库架。在批处理层,将离线批处理从实时速度层中分离出来,在分布式储存系统(如Hadoop的HDFS)高效地处理大数据,将批处理与实时流相结合,确保高吞吐量和低延迟响应,定期处理大量历史数据;在流处理层,使用Apache Storm、Apache Kafka等快速分析新传入的数据以提供低延迟响应;在服务层,将批处理结果与实时视图结合,提供查询服务。Lambda架构最大缺点是维护两个独立的数据管道(批处理和实时)很复杂,需要开发人员为两个系统编写和管理代码,增加了操作成本和维护工作。2014年左右,Jay Kreps提出了Kappa架构,作为Lambda架构的替代方案,该架构通过流处理管道处理所有数据,消除了批处理和速度层的分离,简化了大数据处理,然而,重新处理历史数据可能是资源密集型的,需要从日志中重新计算,这对于大规模数据集而言,仍然非常复杂。受可扩展性、简单性、成本效益需求以及集成AI/ML工作流程的需求驱动,产生了统一架构(Unified Architecture),该架构使用Apache Flink作为处理引擎,或Apache Beam作为统一编程模型,进一步简化了基础架构。随着数据的复杂性和数量不断增长,2020年前后涌现了更多架构,如Data Mesh、 Lakehouse Architecture,这些较新的方法侧重于简化基础设施、有效扩展以及更无缝地将实时处理与批处理工作负载集成在一起。

2000年代的特点是在处理越来越大的数据集时需要可伸缩性,ETL过程变得更加复杂,并且对集成来自不同来源的数据提出了更多要求。

①2000年代初,出现了企业级的处理大型数据集、复杂转换和各种数据源的ETL工具Informatica PowerCenter和Microsoft SQL Server Integration Services (SSIS)。这些ETL工具引入了并行处理,允许多个ETL进程同时运行,从而提高了性能。随着2010年代大数据的兴起,ETL工具发展到可以处理来自不同来源的结构化和非结构化数据(如NoSQL数据库、Hadoop集群和云存储)。Informatica PowerCenter通过Informatica Big Data Edition等工具扩展了与Hadoop集成的能力,使ETL流程能够用于大数据环境。SSIS也增加了对大数据平台的支持,允许用户使用Hive和HDFS等技术连接到Hadoop系统进行数据提取和转换。2010年代后期云迁移是一个主要趋势ETL工具已经发展到可以与各种云平台(如AWS、Azure和Google cloud)集成,Informatica Cloud和Microsoft Azure Data Factory (ADF)作为云原生ETL工具出现,提供跨云环境扩展数据集成任务的能力;SSIS与Azure服务集成,允许在内部部署系统和云之间无缝移动数据,提高灵活性和混合云设置。

②2006年Talend Open Studio推出了最早的开源ETL工具,为用户提供了一个免费的替代昂贵的企业级工具(如Informatica)的选择。Talend引入拖放界面,让非技术用户无需编码即可构建ETL工作流,而更高级的用户仍然可以在必要的地方编写自定义代码。2010年前后大Talend增加了对Apache Hadoop和Spark等大数据平台的支持,允许用户直接在分布式环境中集成和转换大型数据集,增加云产品(例如Talend Cloud)使得跨云和本地系统管理ETL流程成为可能,在追求经济、高效解决方案的中型企业中很受欢迎;2010年后,Talend使用Kafka和Spark streaming等技术支持实时流数据,允许企业集成和处理来自物联网设备或实时事务系统等来源的流数据。Pentaho Data Integration (Kettle)是另一个开源ETL工具,为构建ETL工作流提供了直观的GUI,支持无代码拖拽式构建数据管道,也支持多种数据源。

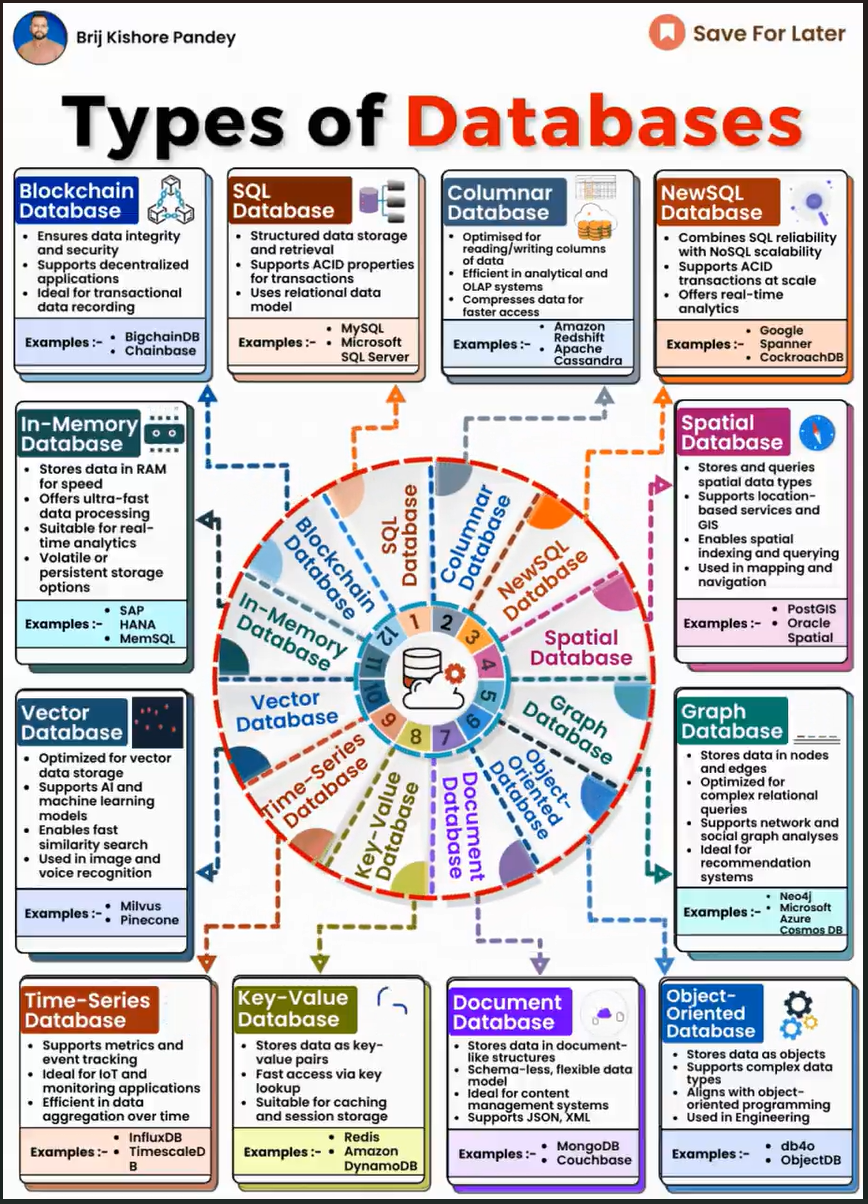

2000年代~2020年代数据规模、复杂性快速增长,数据库类型和适用场景也得到了极大丰富。随着大数据和NoSQL数据库(如MongoDB、Cassandra)的兴起,传统的实体关系(Entity Relation,ER)模型在适应大数据的灵活性和半结构化特性方面面临挑战,ER建模逐渐演变为包含无模式结构(schema-less structures);在软件开发中,常需将业务逻辑(通常使用面向对象编程实现,即OOP)与数据存储(通常使用关系数据库实现)相结合,但OOP和ER模型在表示数据方面不兼容,OOP与ER模型的集成,特别是在ORM(对象关系映射)框架中,很好地解决了数据层和应用程序层之间的对齐问题;为应对处理复杂关系、数据关联性和深度分析探索的需求,2004年Neo Technology发布了Neo4j图数据库,使得数据模型能够更好地反映复杂的关系网络。在近20年的发展历程中,针对不同场景适用的数据库越来越成熟,如SQL数据库、列式数据库、空间数据库、向量数据库等等,见下图:

2000年代后期存储技术从磁盘到内存计算的转变。存储技术由磁盘转向内存计算,大大提高了数据处理速度,允许对事实和维度进行更快的实时聚合和分析,要求维度建模(Dimensional Modeling)适应更快的查询速度和更低的延迟。2010年SAP HANA推出,成为企业级内存数据库的早期产品之一,支持实时处理大量交易和分析数据。2010年SAP HANA使用了列式存储和数据压缩技术,在内存中更高效地存储数据,查询时无需数据聚合,减少了事实和维度的大量预聚合需求,在不影响性能的基础上,使企业能够处理实时报告和高级分析。

2010年前后,大数据越来越被重视,Pentaho创始人詹姆斯·狄克逊(James Dixon)在一篇技术博客中,首次提出用于存储原始、非结构化、半结构化和结构化数据的数据湖(data lake)概念,数据湖作为一种在系统或存储库中以自然格式存储数据的方法,主要用于存储原始数据并执行大数据分析、机器学习、数据挖掘之类的高级分析(有别于数据湖,数据仓库主要在预定义的schema中存储结构化数据),而Amazon S3成为许多数据湖事实上的存储解决方案,允许直接查询存储在云上的数据,而不必将数据加载到仓库中。2020前后云计算逐渐改变组织存储和处理数据的方式,提供了按需可伸缩性、灵活性和成本效益,出现一些基于云的数据仓库和存储解决方案,试图将数据湖的灵活性和可伸缩性与数据仓库的结构、治理和性能结合起来,比如Snowflake提供了一个混合了数据湖和数据仓库元素的多云数据平台,而Databricks则将Apache Spark与Delta Lake集成在一起,在一个统一的系统中提供实时处理和结构化存储。

从2000年到2020年,在大数据、实时处理和可扩展性需求不断增长的推动下,存储技术经历了巨大的变化。从基于磁盘的计算到内存计算的转变,彻底改变了数据处理的速度,而像Apache Spark这样的分布式架构使组织能够更有效地处理更大的数据集。基于云的解决方案和混合存储模型的出现,提供了灵活性和成本效益。到2010年代末,像数据湖这样的统一架构试图解决数据湖和数据仓库面临的挑战。

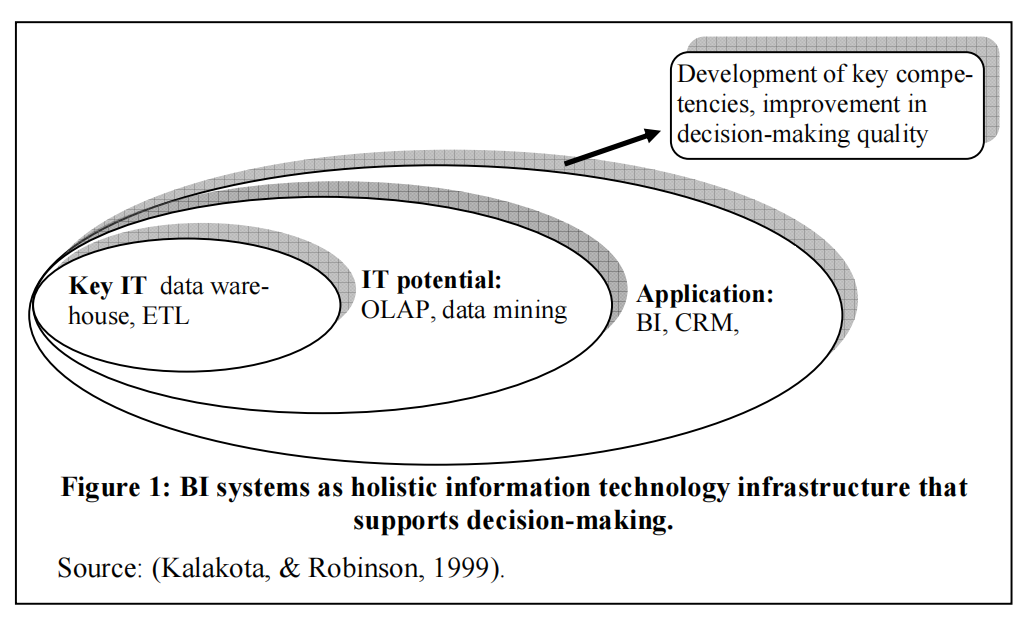

90年代,Gartner在BI系统概念的形式化和普及中发挥了关键作用,但直到2000年IBM发布红皮书《商业智能认证指南》[2]后,BI系统概念内核大致成形:BI系统结合了一套广泛的数据分析应用程序、方法、技术和平台,用于数据存储(数据仓库)、数据挖掘、OLAM(在线分析挖掘)和数据处理(在线分析处理OLAP),如下图。BI系统专注于数据的采集、整合、深入分析及信息的提供,与传统管理信息系统相比,BI系统代表了一个更为广泛的研究范畴,其核心在于对源自不同源头的半结构化数据进行多变量分析,并实现对这些数据的多维度展示与阐释。2015年前后,计算能力和存储技术快速发展,互联网、物联网、社交媒体普及使数据来源呈现多样化,机器学习、深度学习、人工智能算法和工具快读迭代改进,促使大数据(Big Data)、数据挖掘(Data Mining)技术迅速普及到各行业,BI系统概念外延已经扩展到括组织流程和业务流程,涉及到组织决策、数据分析、信息和知识管理、决策流程和过程以及人员交互,BI系统的支撑范围已经从战略决策扩展到运营决策。

图: 典型BI系统构成[3]

在典型的数据分析过程中,首先经过ETL过程(Extract提取、Transform转换、Load加载)从各种源系统中提取数据,然后根据规模将其转换为适合分析的形式并加载到数据仓库或MPP系统中。维度建模技术可用于优化数据结构,使其更适合分析查询,特别是在OLAP系统中。然后通过OLAP工具或其他高级数据分析解决方案对这些数据进行深入分析,以帮助决策者获得有价值的见解,这个过程从数据采集、处理形成了一个完整的链条。

总之,从信息系统、数据技术、数据分析、动态能力、知识管理、数据科学等技术视角,可将BI系统视为一种数据管理与决策分析的技术和手段。

数据和技术本身并不足以构成企业可持续竞争优势的来源(成就了整个互联网,自己最终却一事无成的Xerox公司就是典型),搜集、管理、分析这些商业信息,使数据转化为企业感知机会/威胁、捕获和塑造机遇、调整和配置企业现有的有形和无形资产的动态能力,才帮助企业不断重构企业能力,从而维持与外部环境的动态匹配。进入21世纪以来,BI系统、数据技术与BI软件市场需求同频共振,都有显著增长,哪怕2005年前后,全球正在金融危机中挣扎,企业对最新一代BI系统的投入一直呈增长趋势,2017年全球BI软件市场就已经达到183 亿美元[4],而2019年上半年中国BI软件市场已高达2.1亿美元[5]。总归起来,BI需求的主要驱动因素主要有以下几个方面:

①强制同形(Coercive isomorphism)性影响。因外部压力,诸如法规或行业标准,迫使行业、企业采用BI系统。例如,美国2002年颁布《萨班斯-奥克斯利法案》(SOX),对财务报告和公司治理引入了严格规定,金融企业如摩根大通为确保财务报告的准确和透明,构建了鲁棒性更高的BI系统,以辅助实时跟踪财务绩效、管理内部审计、生成符合SOX的详细报告。

②模仿同形(Mimetic isomorphism)性影响。当第一批受益于BI系统升级的企业涌现时,更多不甘落后的企业涌入赛道,成为追随者,基于自助服务与可视化分析的“业务主导分析”的BI工具在整个行业中传播开来。例如,早期亚马逊将BI系统扩展到供应链、库存、物流和客户服务,来分析用户行为并推荐产品,看到亚马逊取得巨大成功后,eBay、阿里巴巴等公司和规模较小的电子商务初创公司开始大力投资BI系统,以增强他们的推荐引擎、客户洞察力和供应链效率。

③决策过程支持影响。企业经营相关的数据规模性(volume)、快速性(velocity)、多样性(variety)、价值性(value)的大数据特征日渐突出,这给需要收集、分析、呈现数据的决策者,带来了可操作性挑战。决策者需要BI系统能支持探索“发生了什么(数据描述性分析)”“为什么发生(诊断性分析)”“将要发生什么(预见性分析)”“如何做得更好(方案性分析)”。一些最佳实践案例如,可口可乐在供应链管理BI、Netflix的内容推荐系统、亚马逊的库存管理和客户洞察系统等。

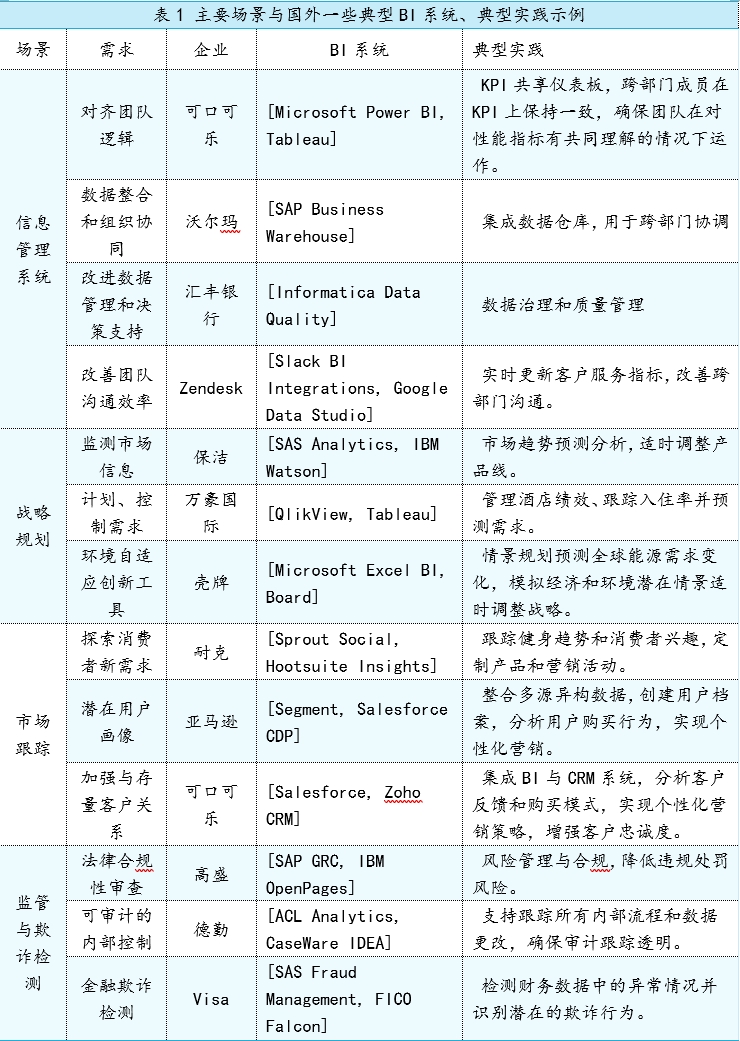

2000年代~2020年代,技术进步提供了现实条件,争取企业竞争优势、适应环境变化的真实需求,使得BI系统从最初支持战略决策,逐渐扩展到运营决策,涵盖了信息管理、战略规划、市场跟踪及监管与欺诈检测等多个应用领域,BI系统通过转化数据为洞察,帮助企业不断适应外部环境,实现动态竞争优势。

通过考察2000-2020年间商业智能(BI)系统的发展历程,可以看到技术进步与商业价值创造之间的深层联系:

1. 技术基础的革新性突破

数据仓库、ETL工具、分布式存储等核心技术的进步为大规模数据处理提供了坚实基础

维度建模与OLAP分析技术的成熟使复杂数据分析成为可能

数据集成能力的提升显著改善了数据价值链的完整性

2. 分析流程的系统化演进

标准化的ETL流程(提取-转换-加载)确保了数据质量与一致性

维度建模方法论的应用优化了分析型数据结构

先进分析工具的出现促进了数据驱动的决策模式

3. 应用范围的持续扩展

从战略决策支持扩展至运营决策优化

应用领域覆盖信息管理、战略规划、市场监测等多个维度

在监管合规与风险控制等领域发挥关键作用

4. 管理与制度理论的延展

丰富了动态能力理论、新制度主义理论在数据管理领域的应用

完善了知识管理与决策支持系统的理论框架

深化了对技术进步与组织适应性之间关系的理解

5. 实践启示

21世纪BI系统已成为组织获取动态竞争优势的关键工具

数据驱动的决策模式要求持续的技术创新与组织变革

企业需要建立完整的数据价值链以实现最大效益

可以说BI系统在21世纪初取得了极大成功,深受大中型企业欢迎,诞生了很多专业的BI产品企业,甚至催生了“数据分析师”一类的职业。尽管如此,进入大数据时代,大中型企业面临新的挑战:业务量和业务类型越来越复杂、变化调整节奏快,但对数据查询结果的准确度、精度要求越来越高;数据量和数据类型庞杂、知识更新迭代快,非常数值型结构化数据占比越来越高;员工赋能周期长、流动性高,经验沉淀困难。传统BI陡峭的学习曲线、数据处理与反馈非即时性、观察维度易偏狭、忽略非数值型结构化文本问题也日渐凸显。

进入2020以后,随着人工智能、大数据、大模型等新技术的发展,BI系统将继续演进:智能分析能力将进一步增强、实时决策支持将成为新常态、数据价值链将更加敏捷和智能化。技术进步不仅带来了工具的革新,更重要的是推动了组织决策模式的根本性变革。在未来,BI系统将在组织的数字化转型中发挥更加核心的作用。

[1] https://x.com/brijpandeyji/status/1830818114390335926

[2] Reinschmidt, J., & Francoise, A. (2000). Business intelligence certification quide. IBM, International Technical Support Organization.

[3]Kalakota, R. & Robinson, M. (1999). E-business: roadmap for success. Addison-Wesley.

[4]Gartner, 2017, “Business Intelligence and Analytics Trends in”

[5]IDC,2019,《2019 年上半年中国商业智能软件市场跟踪报告》